ディープフェイクの脅威と法規制の現在地:企業が講ずべきリスク対策と知財戦略の全貌

はじめに:技術の進化と法規制のギャップについて

こんにちは、株式会社IPリッチのライセンス担当です。

本記事では、急速に進化する生成AI技術の影で深刻な社会問題となっている「ディープフェイク(Deepfake)」について、その技術的背景から、日本および主要各国における最新の法規制状況、そして企業や個人が講じるべき具体的な対策までを網羅的に解説します。AIによる画像・音声生成技術は、クリエイティブな表現の幅を広げる一方で、本物と見分けがつかない偽情報の拡散や、個人の尊厳を傷つける権利侵害のリスクを孕んでいます。特に、ビジネスの現場においては、経営者になりすました詐欺やブランド毀損といった実害が発生しており、もはや対岸の火事ではありません。しかし、現状の日本の法制度は技術の進化に追いついておらず、直接的な規制法が存在しないという課題があります。本記事を通じて、最新のグローバルな規制動向を把握し、自社の知財防衛やリスク管理にお役立ていただければ幸いです。

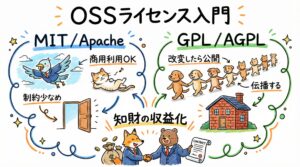

知財の収益化と専門人材の必要性について

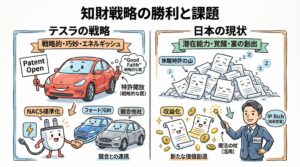

ディープフェイクの問題は、裏を返せば「肖像」や「声」といった個人のアイデンティティがいかに価値ある「知的財産」であるかを如実に物語っています。AI時代において、企業が保有する特許や商標、そして個人のパブリシティ権などの「知財の収益化」は、単なる守りの法務活動にとどまらず、攻めの経営戦略として極めて重要です。適切なライセンス管理や権利保護を徹底することは、模倣品やフェイクコンテンツによる被害を防ぐだけでなく、新たなライセンス収益源を生み出す可能性を秘めています。

こうした高度な知財戦略を構築・実行するためには、専門的な知識と経験を持つ人材が不可欠です。しかし、知財専門職の採用は難易度が高く、多くの企業が課題を抱えています。現在、知財活用に意欲的な企業の皆様に向けて、知財専門の人材マッチングプラットフォーム「PatentRevenue」では、求人情報を無料で登録できるキャンペーンを実施しています。貴社の知財戦略を加速させる優秀なパートナーを見つけるために、ぜひこの機会に活用をご検討ください。

ディープフェイク技術の定義と進化するメカニズム

生成AIが生み出す「本物以上のリアリティ」

ディープフェイクとは、「ディープラーニング(深層学習)」と「フェイク(偽物)」を組み合わせた造語であり、AIを用いて実在する人物の顔や声を別人のものと合成したり、実際には言っていない言葉を自然に発話させたりする技術、およびその生成物を指します 。初期の技術では、不自然な瞬きや口の動き、顔の境界線のズレなどで比較的容易に判別が可能でしたが、近年のGenerative AI(生成AI)の飛躍的な進化により、肉眼や人間の聴覚では真偽の判別がほぼ不可能なレベルに到達しています。

特に懸念されているのが、この技術の「民主化」と「低コスト化」です。かつては高度なエンジニアリングスキルと高価な計算資源(GPUなど)が必要でしたが、現在では安価な、あるいは無料の海外製AIツールやスマートフォンアプリを使用することで、誰でも容易に高度な偽動画や偽音声を作成できてしまいます 。これにより、エンターテインメントの枠を超え、ポルノ画像への悪用(リベンジポルノ)、政治的偽情報の拡散、さらには企業のCEOの声を模倣した金融詐欺(CEO詐欺)など、悪用の事例が急増し、社会的な脅威となっています。

真正性を揺るがす社会的リスクの増大

ディープフェイクの拡散は、「何が真実か」という社会の根本的な信頼基盤を揺るがします。例えば、政治家の発言を捏造した動画が選挙期間中に拡散すれば、有権者の判断を歪め、民主主義の根幹である選挙の公正性が損なわれる恐れがあります 。また、企業にとっては、製品の欠陥を捏造されたり、経営陣が差別的発言をしている偽動画が流布されたりすることで、株価の暴落やブランドイメージの失墜といった甚大な被害を受けるリスクがあります 。このように、技術の進化は利便性だけでなく、従来のセキュリティ対策や法制度では対応しきれない新たな脅威をもたらしているのです。

日本国内における法規制:現行法の適用と限界

刑法および民法による間接的な法的対応

現時点において、日本にはディープフェイクの作成や公開そのものを直接的に禁止・処罰する特別法(いわゆる「ディープフェイク規制法」)は存在しません 。そのため、被害が発生した場合は、既存の刑法や民法を適用して対処することになります。これは「事後的な対処」にならざるを得ないという点で、拡散スピードの速いデジタル犯罪に対して脆弱であると指摘されています。

刑事責任の観点からは、作成されたコンテンツの内容や利用方法に応じて、主に以下の罪に問われる可能性があります 。

- 名誉毀損罪(刑法230条): 公然と事実(または虚偽)を摘示し、人の社会的評価を低下させた場合。ディープフェイクによって「本人がそのような行為をした」と誤信させることは、社会的評価の低下に直結します。

- 侮辱罪(刑法231条): 具体的な事実を摘示せずに公然と人を侮辱した場合。加工の程度が著しく、本人を愚弄するような内容であれば該当する可能性があります。

- わいせつ電磁的記録等送信頒布罪(刑法175条): ディープフェイクポルノなどを不特定多数に提供・公開した場合。被写体の尊厳を傷つける最も悪質な利用例の一つです。

- 著作権法違反: 他人の著作物(映画、ドラマ、CMの映像など)を無断で素材として利用し、改変して公開した場合。翻案権や同一性保持権の侵害となります。

- 業務妨害罪(刑法233条、234条): 虚偽の情報を流して企業の業務を妨害した場合。例えば、企業の信用を毀損する偽動画によって問い合わせ対応に追わせるなどの実害が出たケースです。

肖像権とパブリシティ権による民事上の保護

民事上の責任としては、不法行為(民法709条)に基づく損害賠償請求や差止請求が中心となります。ここでは主に「肖像権」と「パブリシティ権」の侵害が争点となります 。

- 肖像権侵害: 本人の承諾なく、その容姿を撮影・使用された場合に問われます。プライバシー権の一環として保護され、一般人であっても主張可能です。

- パブリシティ権侵害: 芸能人やスポーツ選手など、その顧客吸引力(経済的価値)を無断で商業利用された場合に問われます。ディープフェイクを用いて有名人を広告塔のように見せかける行為は、この権利の侵害となります。

プロバイダ責任制限法の改正と新たな動き

政府も手をこまねいているわけではありません。総務省は、インターネット上の偽・誤情報対策として、プラットフォーム事業者への規律強化を進めています。2024年には「プロバイダ責任制限法」の一部改正法が成立し、名称が「特定電気通信による情報の流通によって発生する権利侵害等への対処に関する法律(情報流通プラットフォーム対処法)」に改められました 。これにより、大規模なプラットフォーム事業者は、削除申請への迅速な対応や運用状況の透明化が義務付けられることになります。しかし、これはあくまで流通プラットフォーム側の対応を促すものであり、ディープフェイク作成者への直接的な罰則強化については、依然として議論の途上にあります。

欧州連合(EU)のAI法:包括的規制と透明性義務

世界初の包括法「EU AI法(EU AI Act)」の成立

日本とは対照的に、欧州連合(EU)ではAI技術に対する包括的かつ厳格な法的枠組みの構築が進んでいます。その筆頭が「EU AI法(EU AI Act)」です 。この法律は、AIシステムを「許容できないリスク」「高リスク」「限定的なリスク」「最小リスク」の4段階に分類し、それぞれに異なる義務を課すという「リスクベースアプローチ」を採用しています。ディープフェイクに関連する生成AI技術の多くは、透明性が求められる「限定的なリスク」あるいは特定の用途では「高リスク」に分類されます。

第50条が課す透明性義務と表示要件

ディープフェイク対策の中核となるのが、同法の第50条(透明性義務)です 。この条項では、AIを用いて生成・操作されたコンテンツについて、以下の義務を規定しています。

- AI生成コンテンツの明示: 人工的に生成または操作された画像、音声、動画コンテンツ(ディープフェイク)を提供する者は、それが人工的に作成されたものであることを明確に開示しなければなりません 。これにより、ユーザーが「本物だ」と誤認することを防ぎます。

- 機械可読なラベル付け: 生成されたコンテンツには、機械が読み取り可能な形式でAI生成であることを示す透かし(ウォーターマーク)やメタデータの埋め込みが求められます 。これは、プラットフォーム側が自動的にAIコンテンツを識別・表示するために不可欠な技術的要件です。

- 例外規定の限定: 芸術的・創造的な作品や、法執行機関による捜査目的など一部の例外を除き、原則としてすべてのディープフェイクコンテンツにこの透明性義務が適用されます 。

この規制の目的は、ディープフェイク技術そのものを禁止することではなく、ユーザーが「今見ているものがAIによって作られたものである」と正しく認識できる環境(透明性)を確保することにあります。違反した企業には、全世界売上高の一定割合という巨額の制裁金が科される可能性があり、EU市場で活動する日本企業にとっても無視できない強力な規制となります。

米国の法規制動向:州ごとのパッチワークとELVIS法

連邦法の不在と各州の独自対応

米国では、EUのような連邦レベルでの包括的なAI規制法はまだ成立しておらず、各州が独自に法律を制定する「パッチワーク」状態となっています 。連邦議会でも議論は進んでいますが、合意形成には至っていません。その結果、州ごとに規制の厳しさや対象範囲が異なり、全米でビジネスを展開する企業にとってはコンプライアンス対応が複雑化するという課題が生じています 。

テネシー州「ELVIS法」による「声」の権利保護

特筆すべき先進事例として、2024年にテネシー州で成立した「ELVIS法(Ensuring Likeness Voice and Image Security Act)」が挙げられます 。テネシー州はナッシュビルを擁する音楽産業の中心地であり、この法律はAIによるアーティストの「声」の無断模倣から権利を守ることを主眼としています。

- 保護対象の拡大: 従来のパブリシティ権法(1984年制定のPersonal Rights Protection Act)を改正し、保護対象として「名前」「肖像」に加え、明示的に「声(Voice)」を追加しました 。

- AI業者への責任追及: 無許可で個人の声や肖像を模倣するディープフェイクを作成・公開する者だけでなく、そのためのツールや技術を提供する業者に対しても民事訴訟を起こす権利を認めています 。これは、ツール開発者にも責任の一端を負わせる画期的な規定です。

- 商業利用以外も対象: 従来は広告利用などが主な規制対象でしたが、ELVIS法ではより広範な無断利用を禁じており、非商用の嫌がらせやなりすましも対象となり得ます 。

カリフォルニア州などにおける政治・選挙関連規制

カリフォルニア州では、選挙期間中の有権者を欺く目的でのディープフェイク利用を規制する法律(AB730など)がいち早く制定されています 。これは、政治的キャンペーンにおいて候補者の言動を捏造した動画が拡散することを防ぐための措置であり、選挙から60日以内の悪意あるディープフェイク配布を禁止しています。また、多くの州(現在14州以上)で、同意のない性的ディープフェイク(ノンコンセンシャル・ポルノ)の作成・配布を犯罪化する動きが加速しており、被害者保護の法整備が進んでいます 。

企業におけるディープフェイクのリスクマネジメント

経営層へのなりすましと「CEO詐欺」

企業にとって最も直接的かつ金銭的な被害をもたらすのが、経営幹部の声をAIで合成した「CEO詐欺(Vishing: Voice Phishing)」です。AIによる音声合成技術(Voice Cloning)は、わずか数秒のサンプル音声があれば高精度な模倣が可能になりつつあります 。実際に海外では、親会社のCEOの声色を模倣した電話を受け取った子会社の代表が、詐欺と気づかずに巨額の資金を指定口座に振り込んでしまった事例も報告されています。電話やオンライン会議でのなりすましを見抜くことは極めて困難になっており、従来の「声による本人確認」はもはや安全とは言えません。

ブランド毀損と偽情報の拡散

企業のブランドイメージを標的とした攻撃も深刻です。例えば、自社製品に異物が混入しているかのような精巧な偽動画がSNSで拡散されたり、CEOが差別的な発言をしているフェイク動画が流布されたりするリスクがあります 。インターネット上の情報は瞬時に拡散するため、たとえそれが偽物であっても、一度「炎上」してしまえば消費者の信頼を一瞬で失い、株価の暴落や不買運動に繋がる恐れがあります。事後的な訂正や削除要請だけでは、拡散したすべての情報を消し去ることは不可能であり、初期対応の遅れが命取りになります。

従業員による意図せぬ情報漏洩と加害リスク

外部からの攻撃だけでなく、内部のリスクも無視できません。従業員が業務効率化のために安易に生成AIツールを使用し、顧客データや機密情報を入力してしまうことで情報漏洩が起きるリスク(シャドーAI)です 。また、従業員が冗談半分や個人的な恨みで同僚の顔写真を加工してディープフェイクを作成し、社内チャットやSNSに投稿すれば、企業としての使用者責任やハラスメント防止義務違反を問われ、訴訟問題に発展するケースも想定されます 。

技術的対抗策:Originator Profile (OP) とC2PA

Originator Profile (OP) 技術による発信者証明

法規制だけでは防ぎきれないディープフェイクに対抗するため、技術的なソリューションの開発も進んでいます。日本国内で注目されているのが「Originator Profile(OP)」技術です 。これは、インターネット上のコンテンツに対して、「誰が発信したのか」という情報を検証可能な形で付与する技術です。

OP技術は、第三者機関がコンテンツ作成者の身元や編集方針を確認し、その情報を改ざん不可能な電子署名としてコンテンツに付与します 。これにより、ユーザーはWebブラウザ上で、その記事や広告が信頼できる正規の発信者(新聞社、放送局、実在する企業など)から送られたものか、あるいは出所不明の偽物かを容易に識別できるようになります。コンテンツの「内容」の真偽をAIで判定するのは困難ですが、「発信者の真正性」を担保することで、信頼できる情報の流通経路を確保しようとするアプローチです。

C2PA規格による来歴管理と改ざん検知

グローバルな技術標準としては、「C2PA(Coalition for Content Provenance and Authenticity)」が普及し始めています 。これは、デジタルコンテンツがいつ、誰によって撮影・作成され、どのような加工(Photoshopでの編集やAIによる生成など)が施されたのかという「来歴情報(Provenance)」をファイル自体に記録する技術規格です。

Microsoft、Adobe、Intel、BBCなどが主導しており、カメラで撮影した瞬間から編集、公開に至るまでの履歴を暗号技術を用いて記録することで、画像の改ざんやAI生成の有無を追跡可能にします 。C2PAに対応した画像であれば、視聴者はその画像がAIで作られたものか、実写であるかを確認する手段を持つことができます。

企業が策定すべきガイドラインとクライシス対応

生成AI利用ガイドラインの策定と周知

企業は、ディープフェイクのリスクを最小化するために、従業員向けの「生成AI利用ガイドライン」を早急に策定・周知する必要があります 。

- 入力データの制限: 個人情報、顧客情報、未公開の機密情報をAIツールに入力することを禁止する。

- 権利侵害の防止: 第三者の著作権や肖像権を侵害するようなコンテンツ生成を行わないよう、チェック体制を敷く。

- 生成物の明示: 自社がAIを用いて作成した広告やコンテンツを公開する際は、「AIにより生成」等の表示を行うポリシーを定める(透明性の確保)。一般社団法人日本ディープラーニング協会(JDLA)などが公開しているガイドラインの雛形を活用し、自社の業務実態に合わせたルール作りを行うことが推奨されます 。

ディープフェイク特化型の危機管理広報

万が一、自社の偽動画が拡散した場合に備え、従来の危機管理マニュアルを「ディープフェイク対応型」にアップデートする必要があります 。

- 早期検知体制の構築: ソーシャルリスニングツールなどを導入し、自社ブランドや役員名、製品名に関する不審な動画・画像を常時モニタリングする 。

- 迅速な事実確認(ファクトチェック): 疑わしいコンテンツが発見された際、即座に真正性を検証するフローを確立しておく。自社で判断が難しい場合は、デジタルフォレンジックの専門家と連携できる体制を作っておくことが有効です 。

- 透明性のあるコミュニケーション: ディープフェイク被害に遭った際は、隠蔽せず速やかに「それは偽物である」と公式声明を出すことが、ステークホルダーからの信頼維持に繋がります 。沈黙は肯定と受け取られるリスクがあるため、スピードが命です。

- 証拠の保全: 削除要請や法的措置を見据え、発見されたディープフェイク動画や拡散元のURL、スクリーンショットなどの証拠を確実に保全する手順を定めておきます 。

おわりに

ディープフェイク技術は、私たちの社会に「目に見えるものが真実とは限らない」という新たな常識を突きつけました。法規制は欧米を中心に進みつつありますが、技術の進化スピードは常に法律の一歩先を行きます。したがって、法整備を待つだけでなく、Originator Profileのような技術的ソリューションの導入や、企業ごとの自主的なガバナンス強化が不可欠です。

私たちIPリッチは、知的財産のプロフェッショナルとして、技術と法律の両面から皆様のビジネスを守り、育てる支援を続けてまいります。AI時代における知財リスクや収益化について、お悩みがあればいつでもご相談ください。

(この記事はAIを用いて作成しています。)

参考文献リスト

刑事事件弁護士ナビ, “ディープフェイクポルノ作成は名誉毀損罪や著作権法違反!,” https://keijibengo-line.com/post-11464/

Burk Law Firm, “Do AI Laws Differ by State?,” https://burklaw.com/2025/08/do-ai-laws-differ-by-state/

Entrust, “Deepfake law: EU AI Act and regulation,” https://www.entrust.com/blog/2024/02/deepfake-law

Georgetown Law Technology Review, “Deepfakes: The Current Legal Landscape,” https://georgetownlawtechreview.org/wp-content/uploads/2023/01/Geng-Deepfakes.pdf

MultiState, “More and More States Are Enacting Laws Addressing AI Deepfakes,” https://www.multistate.us/insider/2024/4/5/more-and-more-states-are-enacting-laws-addressing-ai-deepfakes

Columbia Journal of European Law, “Deepfake, Deep Trouble,” https://cjel.law.columbia.edu/preliminary-reference/2024/deepfake-deep-trouble-the-european-ai-act-and-the-fight-against-ai-generated-misinformation/

富士ソフト, “ディープフェイクの脅威と対策,” https://www.fsi.co.jp/techtips/quick/1277/

Adams and Reese LLP, “ELVIS Act: Tennessee Safeguards Against Deepfakes,” https://www.adamsandreese.com/insights/elvis-act-tennessee-safeguards-against-deepfakes/

Skadden, Arps, Slate, Meagher & Flom LLP, “Tennessee Law Addresses Proliferation of Deepfakes,” https://www.skadden.com/insights/publications/2024/04/tennessee-law-addresses-proliferation-of-deepfakes

Latham & Watkins LLP, “The ELVIS Act: Tennessee Shakes Up Its Right of Publicity Law,” https://www.lw.com/admin/upload/SiteAttachments/The-ELVIS-Act-Tennessee-Shakes-Up-Its-Right-of-Publicity-Law-and-Takes-On-Generative-AI.pdf

Reed Smith LLP, “Tennessee efforts protect ROP against GenAI imitations deepfakes,” https://www.reedsmith.com/articles/tennessee-efforts-protect-rop-against-genai-imitations-deepfakes/

Baker Donelson, “New Legislation Proposed in Tennessee to Protect Against Deepfakes (ELVIS Act),” https://www.bakerdonelson.com/new-legislation-proposed-in-tennessee-to-protect-against-deepfakes-elvis-act

EU AI Act, “Key Issue: Transparency,” https://www.euaiact.com/key-issue/5

EU AI Act, “Article 50,” https://artificialintelligenceact.eu/article/50/

European Commission, “AI Act: Article 50,” https://ai-act-service-desk.ec.europa.eu/en/ai-act/article-50

JIPITEC, “Article 50 AI Act,” https://www.jipitec.eu/jipitec/article/view/438

WilmerHale, “Limited-Risk AI—A Deep Dive Into Article 50,” https://www.wilmerhale.com/en/insights/blogs/wilmerhale-privacy-and-cybersecurity-law/20240528-limited-risk-ai-a-deep-dive-into-article-50-of-the-european-unions-ai-act

刑事事件弁護士ナビ, “ディープフェイクポルノ作成は名誉毀損罪や著作権法違反!,” https://keijibengo-line.com/post-11464/

Burk Law Firm, “Do AI Laws Differ by State?,” https://burklaw.com/2025/08/do-ai-laws-differ-by-state/

Entrust, “Deepfake law: EU,” https://www.entrust.com/blog/2024/02/deepfake-law

Georgetown Law Technology Review, “Deepfakes,” https://georgetownlawtechreview.org/wp-content/uploads/2023/01/Geng-Deepfakes.pdf

MultiState, “States enacting laws addressing AI deepfakes,” https://www.multistate.us/insider/2024/4/5/more-and-more-states-are-enacting-laws-addressing-ai-deepfakes

Columbia Journal of European Law, “The Deepfake Dilemma,” https://cjel.law.columbia.edu/preliminary-reference/2024/deepfake-deep-trouble-the-european-ai-act-and-the-fight-against-ai-generated-misinformation/

富士ソフト, “ディープフェイクの悪用事例と対策,” https://www.fsi.co.jp/techtips/quick/1277/

TaskHub, “企業が生成AI利用ガイドラインで対策すべきリスク,” https://taskhub.jp/useful/generative-ai-company-guidelines/

総務省, “令和6年版 情報通信白書:プラットフォームサービスに関する研究会,” https://www.soumu.go.jp/johotsusintokei/whitepaper//ja/r07/text/nd226310.txt

Originator Profile技術研究組合, “Originator Profile 技術 仕組み,” https://originator-profile.org/ja-JP/overview/

PR TIMES, “AIタレント動画生成サービス「AvaMo」,” https://prtimes.jp/main/html/rd/p/000000404.000000204.html

ジールセキュリティ, “不測のSNS炎上に備える、危機管理の初期初動,” https://zeal-security.jp/blog/crisis_communication/

Sparklight, “Navigating a Deepfake Crisis,” https://business.sparklight.com/enterprise/blog/navigating-deepfake-crisis-guide-enterprise-businesses

Brilliance Security Magazine, “Protecting Crisis Communications from AI Deepfake Attacks,” https://brilliancesecuritymagazine.com/cybersecurity/protecting-crisis-communications-from-ai-deepfake-attacks/

Agility PR, “Crisis communications in the age of deepfakes,” https://www.agilitypr.com/pr-news/crisis-comms-media-monitoring/crisis-communications-in-the-age-of-deepfakes-what-pr-teams-must-prepare-for/

ZeroFox, “How to Create a Deepfake Incident Response Plan,” https://www.zerofox.com/blog/how-to-create-a-deepfake-incident-response-plan-a-practical-framework-for-security-teams/

10 to 1 Public Relations, “Navigating the Deepfake Crisis,” https://10to1pr.com/deepfake-crisis-management/